梯度下降算法详解:与损失函数的关系及应用

梯度下降算法详解:与损失函数的关系及应用

梯度下降算法是一种迭代优化算法,广泛应用于机器学习领域,其目标是找到模型参数的最优解,以最小化损失函数。

什么是损失函数?

损失函数是用来衡量机器学习模型预测结果与真实值之间差距的函数。损失函数值越小,代表模型预测越准确。常见的损失函数包括均方误差损失函数、交叉熵损失函数等。

梯度下降算法原理

梯度下降算法的核心思想是:利用损失函数的梯度信息,迭代更新模型参数,使损失函数值逐步减小,直至达到最小值或收敛条件。

具体来说,梯度下降算法的步骤如下:

- 初始化模型参数:随机设置模型参数的初始值。

- 计算损失函数梯度:根据当前参数值,计算损失函数对每个参数的偏导数,即梯度。梯度指示了损失函数值增大的方向。

- 更新模型参数:沿着梯度的反方向更新参数值,更新步长由学习率决定。

- 重复步骤2-3:迭代更新参数,直至损失函数值收敛到最小值或满足停止条件。

梯度下降算法与损失函数的关系

梯度下降算法依赖于损失函数的梯度信息来更新参数,损失函数的选择直接影响梯度下降算法的性能。

- 不同的损失函数适用于不同的机器学习任务和数据类型。

- 损失函数的平滑程度、凸性等性质也会影响梯度下降算法的收敛速度和稳定性。

梯度下降算法的应用

梯度下降算法在机器学习中应用广泛,例如:

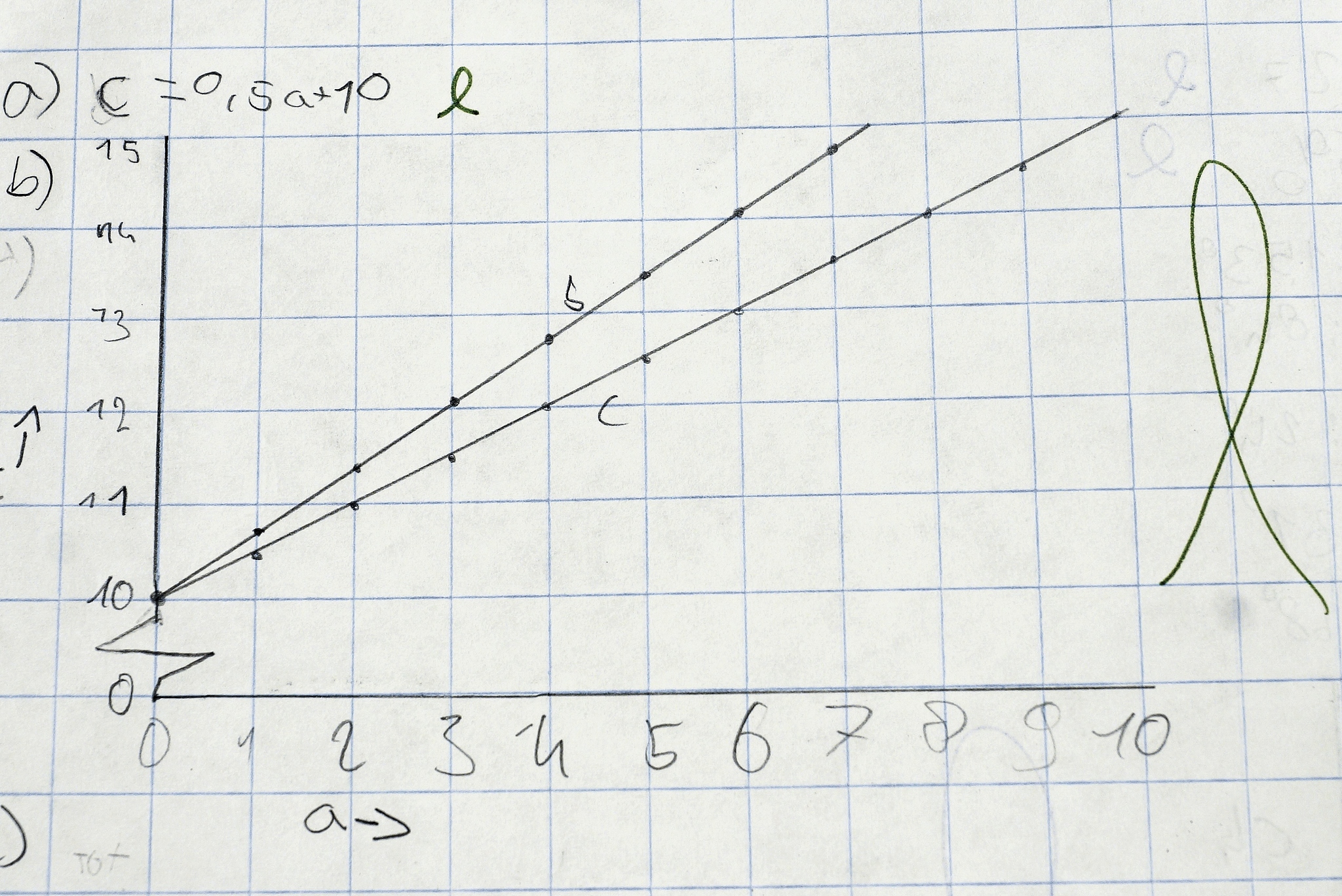

- 线性回归:找到最佳拟合直线或超平面的参数。

- 神经网络:训练神经网络的权重和偏置,以实现图像识别、自然语言处理等任务。

总结

梯度下降算法是一种简单有效且应用广泛的优化算法,其与损失函数密切相关。选择合适的损失函数和梯度下降算法对机器学习模型的训练效果至关重要。

原文地址: https://www.cveoy.top/t/topic/jjrG 著作权归作者所有。请勿转载和采集!