1阐述Hardoop平台搭建与实现一个大数据案例分析的思路。

Hadoop平台搭建与实现一个大数据案例分析的思路如下:

-

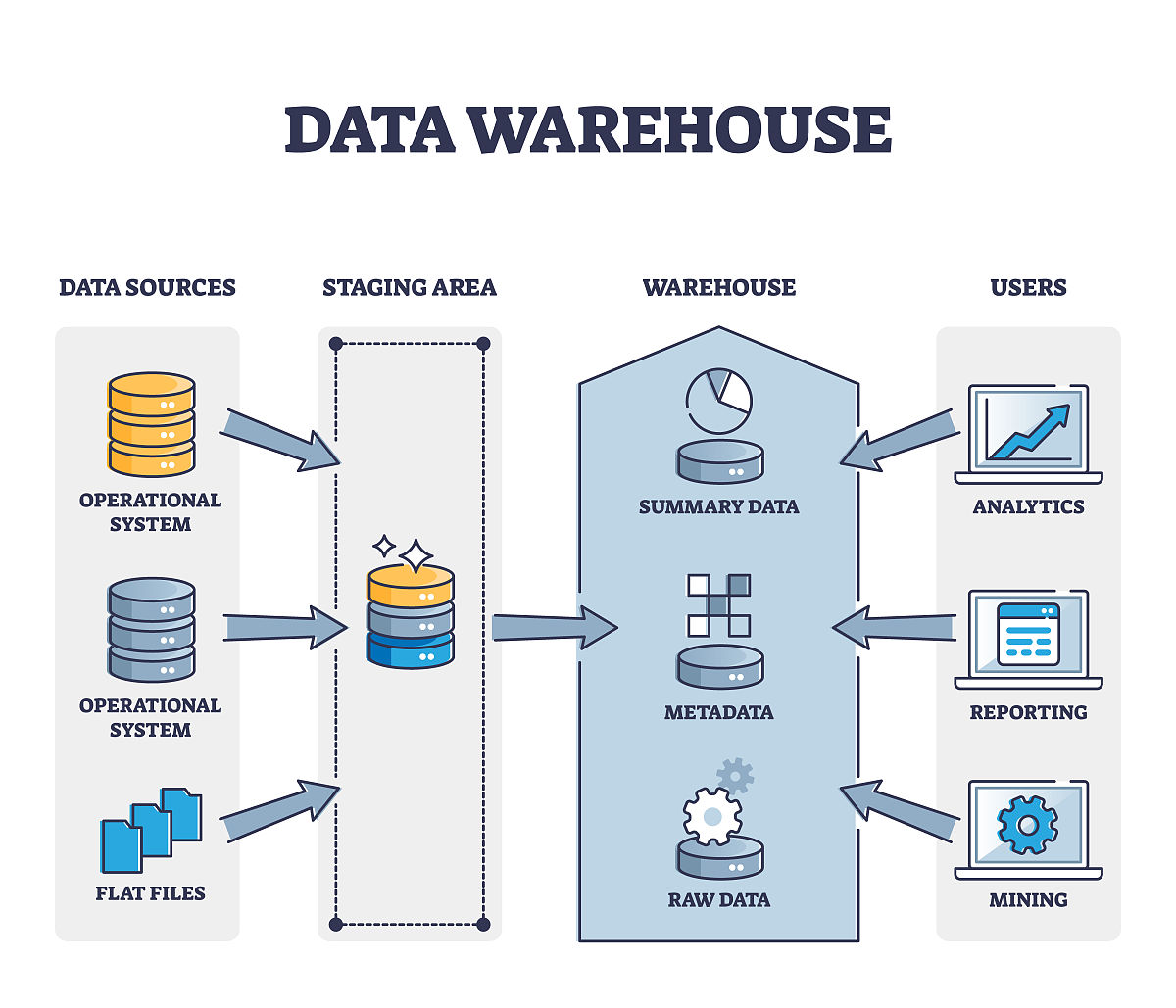

首先,需要在服务器上安装Hadoop平台,包括Hadoop集群、HDFS、YARN和MapReduce等组件,以便进行大数据存储和处理。

-

然后,需要准备大数据案例的数据源,这可以是结构化数据、半结构化数据或非结构化数据。例如,可以使用Apache Kafka或Apache Flume等工具将实时数据流传输到Hadoop平台中。

-

接下来,需要进行数据清洗和处理,包括数据清洗、数据集成、数据转换和数据聚合等操作。可以使用Hadoop平台中的MapReduce或Spark等工具进行数据处理。

-

在数据处理完成后,可以使用Hadoop平台中的可视化工具,如Apache Zeppelin或Hue等,对数据进行可视化分析,以便更好地理解数据。

-

最后,可以使用机器学习算法对数据进行建模和预测分析,例如使用Hadoop平台中的Mahout或Spark MLlib等工具进行机器学习。

总的来说,Hadoop平台搭建与实现一个大数据案例分析的思路包括数据准备、数据处理、数据可视化和机器学习分析等环节,需要结合不同的工具和技术进行实现

原文地址: https://www.cveoy.top/t/topic/eCE5 著作权归作者所有。请勿转载和采集!