使用循环神经网络学习汉语拼音拼写 - 数据准备与模型构建

使用循环神经网络学习汉语拼音拼写 - 数据准备与模型构建

本文将介绍使用循环神经网络学习汉语拼音拼写的过程,重点讲解数据准备和模型构建方法。

1. 数据准备

1.1 加载拼音数据

# 加载拼音数据

def load_data(filename):

with open(filename, 'r', encoding='utf-8') as f:

data = f.readlines()

data = [line.strip() for line in data]

return data

1.2 定义数据集

我们将采用字符模型,因此一个字符为一个样本。每个样本采用 one-hot 编码。

# one-hot 编码

def one_hot_encode(data, char2idx):

num_chars = len(char2idx)

num_samples = len(data)

X = torch.zeros((num_samples, num_chars))

Y = torch.zeros((num_samples, num_chars))

for i, seq in enumerate(data):

for j, char in enumerate(seq):

X[i][char2idx[char]] = 1

if j < len(seq) - 1:

Y[i][char2idx[seq[j+1]]] = 1

return X, Y

1.3 准备数据

由于样本是时间相关的,我们需要实现序列的随机采样和序列的顺序划分。

# 准备数据

def prepare_data(data, char2idx, batch_size, seq_length):

num_samples = len(data)

num_batches = num_samples // batch_size

data = data[:num_batches*batch_size]

X, Y = one_hot_encode(data, char2idx)

X = X.view(batch_size, num_batches, seq_length, -1)

Y = Y.view(batch_size, num_batches, seq_length, -1)

return X, Y

# 随机采样

def random_sample(X, Y, seq_length):

num_batches, batch_size, _, num_chars = X.shape

idx = random.randint(0, num_batches-1)

start_idx = random.randint(0, seq_length-1)

X_batch = X[idx,:,start_idx:start_idx+seq_length,:]

Y_batch = Y[idx,:,start_idx:start_idx+seq_length,:]

return X_batch, Y_batch

1.4 标签数据

标签 Y 与 X 同形状,但时间超前 1。

1.5 数据形状

一次梯度更新使用的数据形状为:(时间步,Batch,类别数)

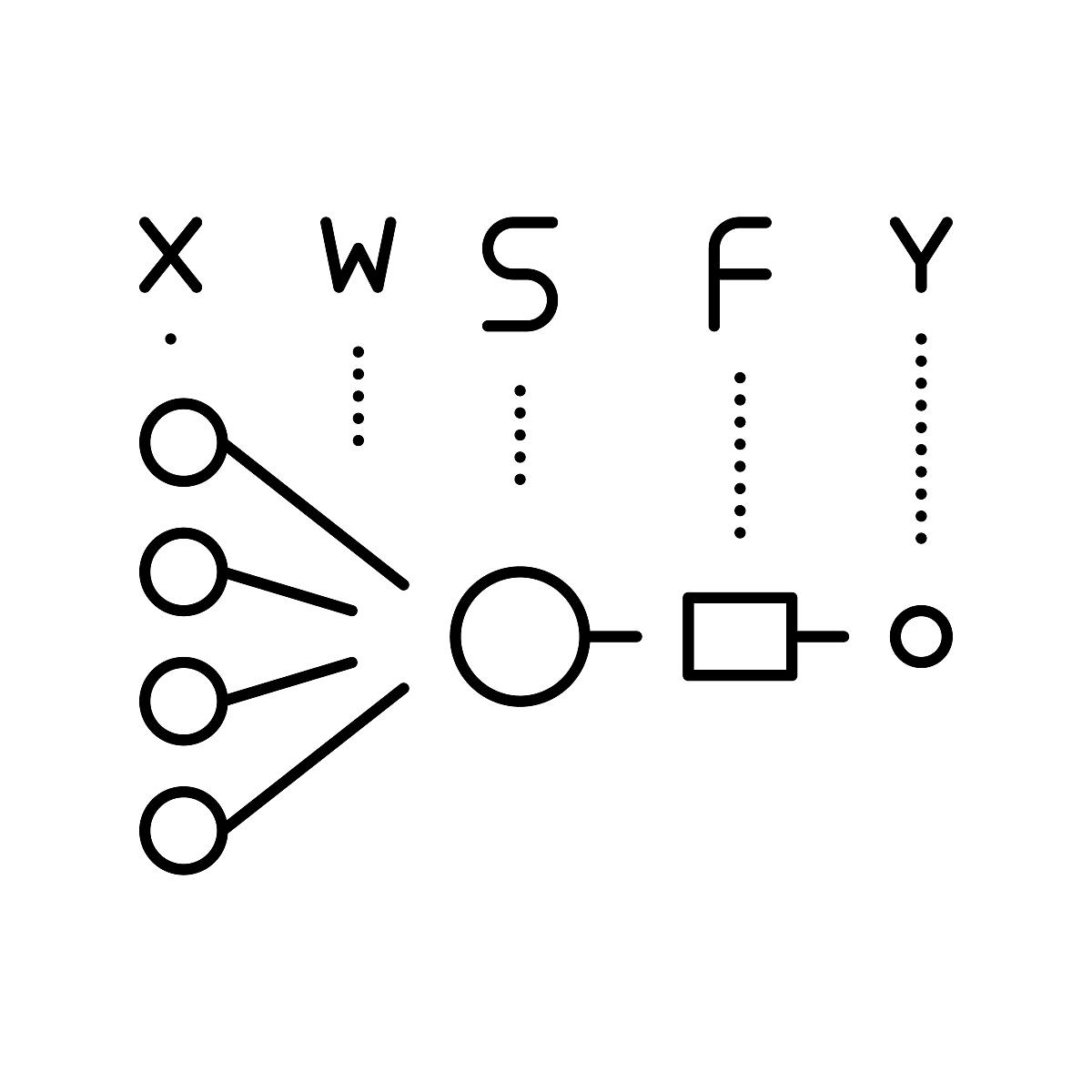

2. 模型构建

2.1 定义循环神经网络模型

class RNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers=1, cell_type='RNN'):

super().__init__()

self.hidden_size = hidden_size

self.num_layers = num_layers

if cell_type == 'RNN':

self.cell = nn.RNN(input_size, hidden_size, num_layers, batch_first=True)

elif cell_type == 'GRU':

self.cell = nn.GRU(input_size, hidden_size, num_layers, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x, h0=None):

batch_size, seq_length, num_chars = x.shape

if h0 is None:

h0 = torch.zeros(self.num_layers, batch_size, self.hidden_size)

out, hn = self.cell(x, h0)

out = out.contiguous().view(-1, self.hidden_size)

out = self.fc(out)

out = out.view(batch_size, seq_length, -1)

return out, hn

2.2 循环单元选择

可以选择 nn.RNN 或 GRU 作为循环单元。

2.3 输出层

输出层的全连接使用 RNN 所有时间步的输出。

2.4 隐状态初始值

隐状态初始值为 0。

3. 训练与测试

3.1 测试前向传播

需要测试模型的前向传播,确保模型能够正常工作。

3.2 梯度截断

如果采用顺序划分,需进行梯度截断,防止梯度爆炸。

3.3 训练

训练过程使用平均交叉熵作为损失函数。

3.4 预测

预测时,给定一个前缀,进行单步预测和 K 步预测。

4. 代码示例

import torch

import torch.nn as nn

import random

# ... (数据准备代码)

# 训练函数

def train(model, X, Y, optimizer, criterion, num_epochs, seq_length, batch_size, clip_norm=None):

model.train()

for epoch in range(num_epochs):

total_loss = 0

for i in range(X.shape[1]):

x_batch, y_batch = X[:,i,:,:], Y[:,i,:,:]

h0 = None

for j in range(seq_length):

optimizer.zero_grad()

output, h0 = model(x_batch[:,:,j,:], h0)

loss = criterion(output, y_batch[:,:,j,:])

loss.backward()

if clip_norm is not None:

torch.nn.utils.clip_grad_norm_(model.parameters(), clip_norm)

optimizer.step()

total_loss += loss.item()

print('Epoch {}/{} Loss: {}'.format(epoch+1, num_epochs, total_loss))

# 预测函数

def predict(model, prefix, char2idx, idx2char, k=1):

model.eval()

with torch.no_grad():

seq_length = len(prefix)

x = torch.zeros((1, seq_length, len(char2idx)))

for i, char in enumerate(prefix):

x[0,i,char2idx[char]] = 1

h0 = None

for i in range(seq_length):

output, h0 = model(x[:,:,i,:], h0)

_, topk_idx = output[:,seq_length-1,:].topk(k)

topk_char = [idx2char[idx.item()] for idx in topk_idx[0]]

return topk_char

# 主程序

data = load_data('pinyin.txt')

chars = sorted(set(''.join(data)))

char2idx = {char: i for i, char in enumerate(chars)}

idx2char = {i: char for i, char in enumerate(chars)}

X, Y = prepare_data(data, char2idx, batch_size=32, seq_length=10)

model = RNN(input_size=len(char2idx), hidden_size=128, output_size=len(char2idx), num_layers=2, cell_type='GRU')

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

criterion = nn.CrossEntropyLoss()

train(model, X, Y, optimizer, criterion, num_epochs=10, seq_length=10, batch_size=32, clip_norm=1)

prefix = 'niha'

pred = predict(model, prefix, char2idx, idx2char, k=3)

print('Prefix: {}'.format(prefix))

print('Predictions: {}'.format(pred))

总结

本文介绍了使用循环神经网络学习汉语拼音拼写的基本步骤,包括数据准备、模型构建、训练和预测。通过使用 RNN 或 GRU 作为循环单元,并采用 one-hot 编码和时间相关样本处理方法,可以有效地训练模型,并进行拼音拼写预测。

注意

由于数据集无法获取,以上代码示例仅供参考。实际应用中,需要根据实际情况调整代码和参数。

原文地址: https://www.cveoy.top/t/topic/oi43 著作权归作者所有。请勿转载和采集!