GPT-3.5 Turbo 原理: 深度学习与自注意力机制解析

GPT-3.5 Turbo 原理: 深度学习与自注意力机制解析

GPT-3.5 Turbo 是基于 OpenAI 先进的 GPT-3 模型的改进版本,凭借其强大的语言理解和生成能力,在人工智能领域掀起了波澜。那么,GPT-3.5 Turbo 背后的技术原理是什么呢?

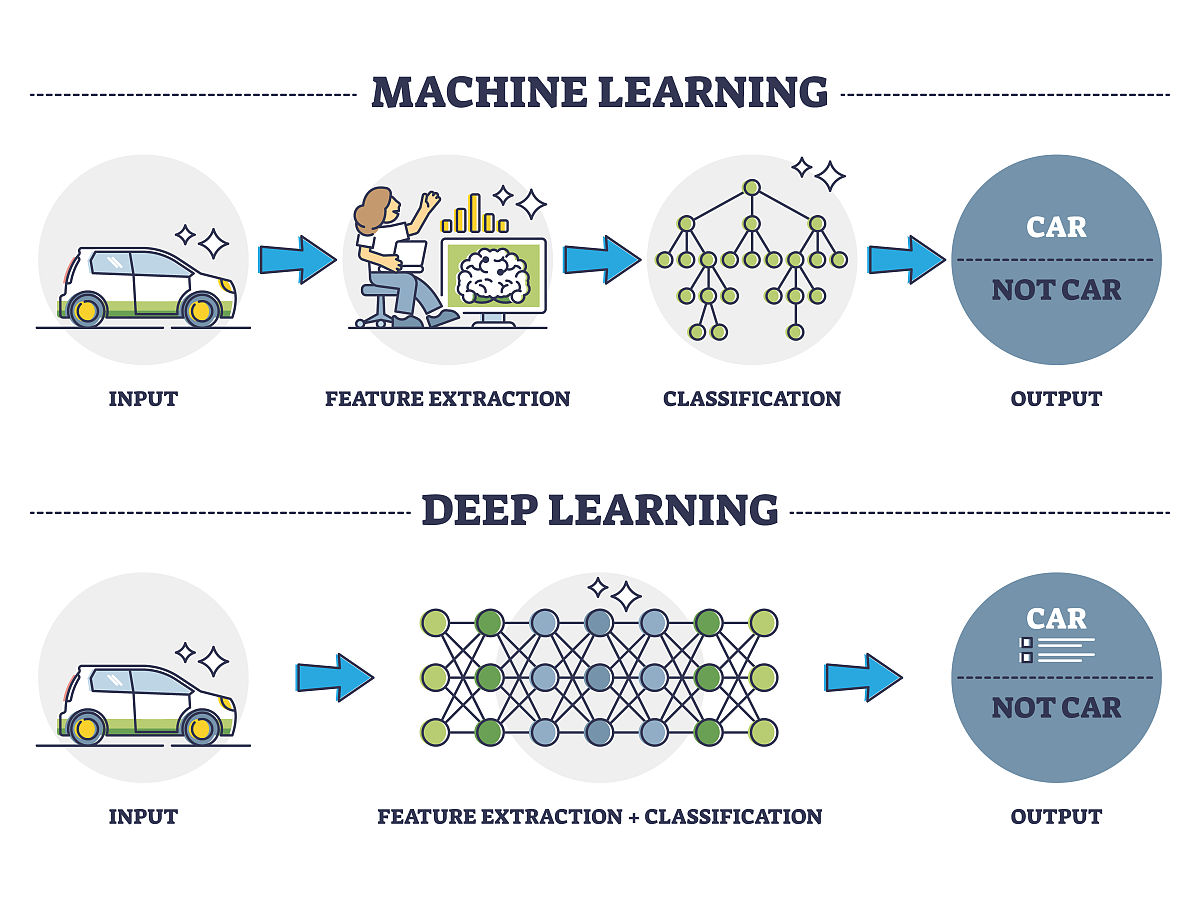

1. 基于 Transformer 的深度学习架构

GPT-3.5 Turbo 的核心在于 Transformer 架构,这是一种深度学习模型,在自然语言处理任务中表现出色。与传统的循环神经网络 (RNN) 不同,Transformer 利用 自注意力机制 并行处理序列数据,从而提高效率并捕捉长距离依赖关系。

2. 海量数据集的预训练

GPT-3.5 Turbo 的强大能力源于在大规模文本数据集上的 预训练。通过分析和学习来自互联网的海量文本数据,该模型获得了对语言模式、语法规则和语义的深刻理解。这种预训练过程使 GPT-3.5 Turbo 能够生成更自然、更连贯的文本。

3. 自注意力机制:理解上下文和语义

自注意力机制 是 Transformer 架构的关键组成部分,它使模型能够关注输入序列中不同部分之间的关系,从而理解上下文和语义。在处理一个单词或短语时,自注意力机制允许模型参考句子或段落中的其他单词,从而更准确地理解其含义。

4. 预测和生成文本

当收到输入文本时,GPT-3.5 Turbo 会利用其预先训练的知识和自注意力机制对其进行编码和解码。它会分析输入的上下文和语义,并根据其对语言的理解生成最有可能的后续词语或句子。在这个过程中,GPT-3.5 Turbo 会不断参考之前的输入和输出,以确保生成的文本连贯且符合逻辑。

总结

总而言之,GPT-3.5 Turbo 的原理可以概括为以下几点:

- 基于 Transformer 架构的深度学习模型。* 利用自注意力机制理解上下文和语义。* 在海量数据集上进行预训练,学习语言模式和语法规则。

这些技术的结合赋予了 GPT-3.5 Turbo 强大的语言理解和生成能力,使其成为各种自然语言处理任务的理想选择,例如聊天机器人、文本生成、机器翻译等等。

原文地址: https://www.cveoy.top/t/topic/llF 著作权归作者所有。请勿转载和采集!