batchsize设为1在一张卡上还放不下 怎么办

如果batchsize设为1在一张卡上放不下,你可以考虑以下几种解决方案:

-

减小模型的大小:可以通过减小模型的参数量或者减少层数来减小模型的大小,从而使得batchsize为1可以在一张卡上放下。

-

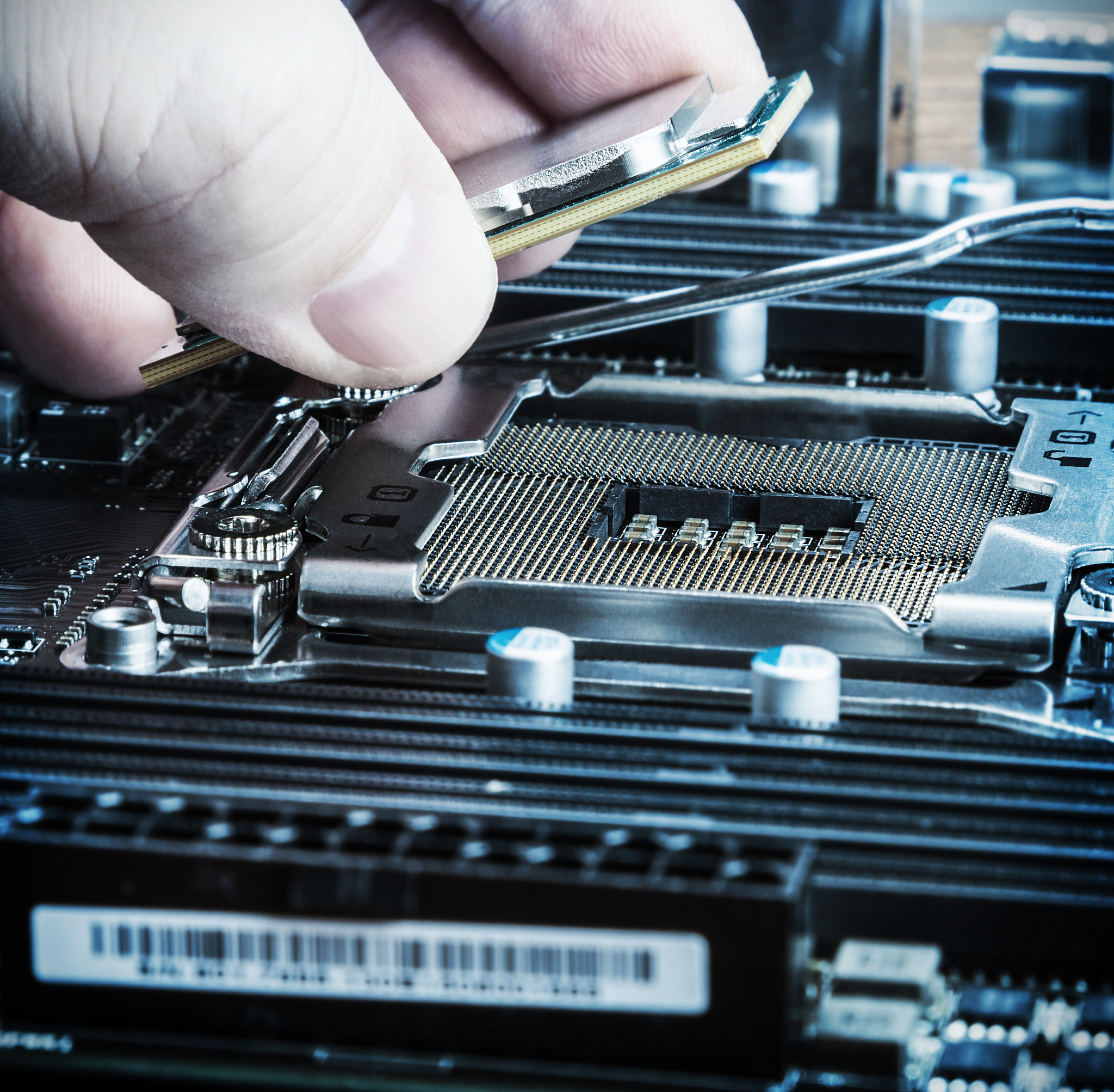

使用更大的显存的卡:如果你的显卡的显存较小,可以考虑升级到显存更大的显卡,这样可以支持更大的batchsize。

-

使用分布式训练:如果你有多张显卡可以使用,可以考虑使用分布式训练的方式,将训练的数据分布到多张显卡上进行训练。

-

使用梯度累积:可以将多个batch的梯度进行累积,然后再进行一次参数更新,这样可以达到使用更大的batchsize的效果。

-

使用混合精度训练:可以使用混合精度训练的方式,在计算过程中使用半精度浮点数来减小显存的占用,从而支持更大的batchsize。

-

数据并行训练:可以将数据分成多个部分,分别加载到不同的显卡上进行训练,然后将各个显卡的梯度进行累积或者求平均,再进行参数更新。

需要根据具体情况选择合适的解决方案,可以根据自己的硬件条件和模型大小来进行调整。

原文地址: https://www.cveoy.top/t/topic/hYkh 著作权归作者所有。请勿转载和采集!