数学建模回归分析知识点

回归分析是一种用于研究变量之间关系的统计方法。它可以帮助我们了解一个或多个自变量对一个因变量的影响程度,以及这种关系是否显著。下面是一些常见的数学建模回归分析的知识点:

-

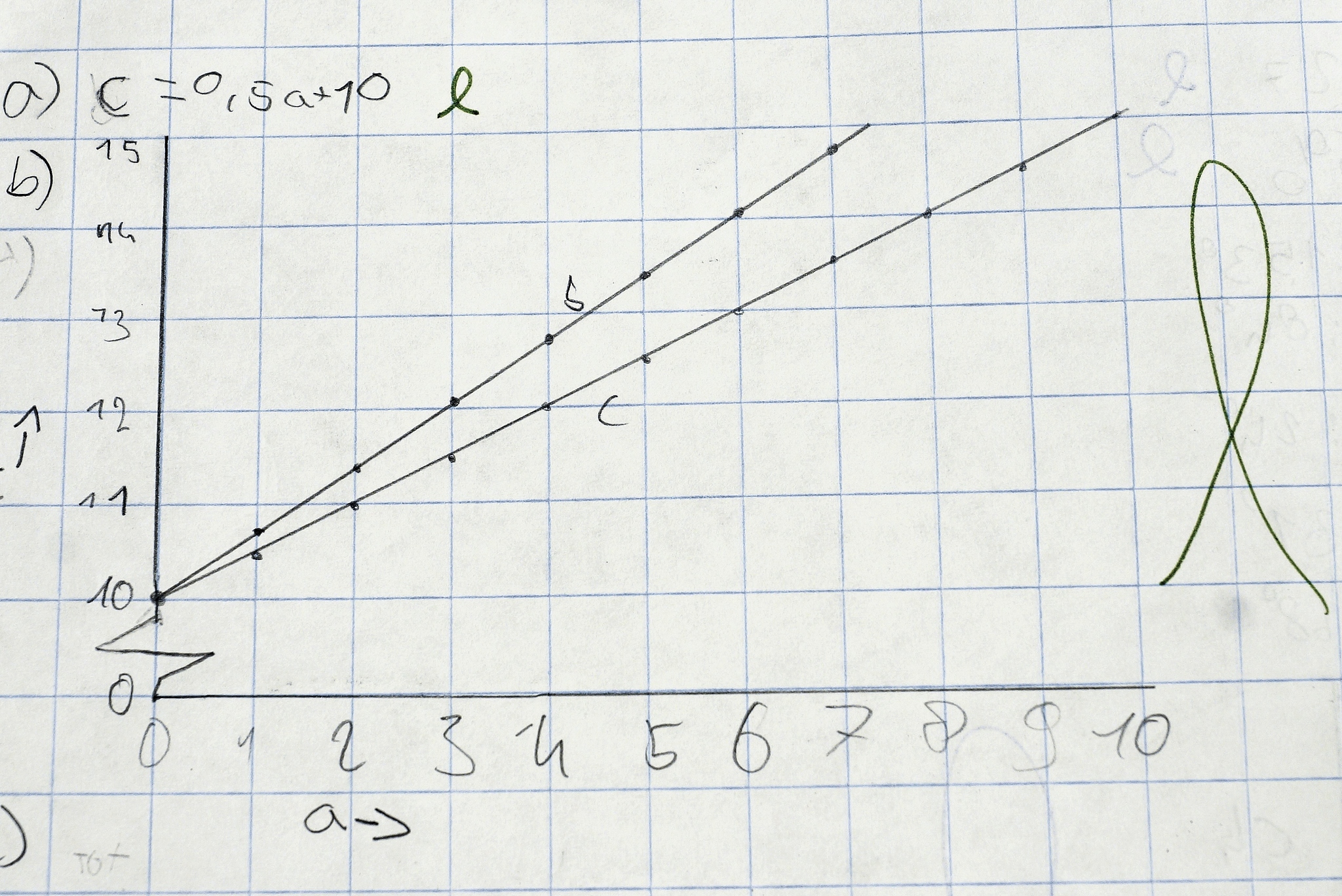

简单线性回归:当只有一个自变量和一个因变量时,可以使用简单线性回归来建立模型。回归方程可以表示为 Y = β0 + β1X + ε,其中 Y 是因变量,X 是自变量,β0 和 β1 是回归系数,ε 是误差项。

-

多元线性回归:当有多个自变量时,可以使用多元线性回归建立模型。回归方程可以表示为 Y = β0 + β1X1 + β2X2 + ... + βnXn + ε,其中 Y 是因变量,X1, X2, ..., Xn 是自变量,β0, β1, β2, ..., βn 是回归系数,ε 是误差项。

-

回归系数估计:回归系数可以使用最小二乘法来估计。最小二乘法是一种最小化观测值与回归线之间的距离平方和的方法,以获得最佳的回归系数估计。

-

拟合优度:拟合优度是用于衡量回归模型拟合数据的程度。常见的拟合优度指标包括 R-squared(决定系数)、调整 R-squared、F统计量等。

-

假设检验:在回归分析中,可以进行假设检验来判断回归系数是否显著。常见的假设检验包括 t检验和 F检验。

-

多重共线性:多重共线性指的是自变量之间存在高度相关性的情况。多重共线性会导致回归系数估计不准确,模型解释能力下降。可以使用方差膨胀因子(VIF)来检测自变量之间的多重共线性。

-

非线性回归:当因变量和自变量之间的关系不是线性的时候,可以使用非线性回归建立模型。常见的非线性回归模型包括指数模型、对数模型、多项式模型等。

-

异常值和离群值处理:在回归分析中,异常值和离群值可能会对模型拟合产生较大影响。可以使用统计方法来识别和处理异常值,例如删除异常值、替换异常值、使用鲁棒回归等。

以上只是回归分析中的一些常见知识点,实际应用中可能还涉及到更多的技术和方法

原文地址: https://www.cveoy.top/t/topic/hUkO 著作权归作者所有。请勿转载和采集!