请同学们结合教材以及网络查找Hadoop的9大组件的知识--①分布式存储系统②MapReduce分布式计算框架③YARN资源管理平台④Sqoop数据迁移工具⑤Mahout数据挖掘算法库⑥HBase分布式数据库⑦Zookeeper分布式协调服务⑧Hive数据仓库⑨Flume日志收集工具请准备一个word文件在文件中简述上述9大组件的作用以及你查找和研究hadoop的各大组件后对hadoop的认知和感

Hadoop的9大组件的作用以及对Hadoop的认知和感悟:

-

分布式存储系统:Hadoop的分布式存储系统是基于Hadoop分布式文件系统(HDFS)实现的。它将数据切分成多个块,并分布在多台服务器上存储,实现了数据的高可靠性和高可扩展性。

-

MapReduce分布式计算框架:MapReduce是Hadoop的核心组件之一,用于实现分布式计算任务。它将大数据集划分成小的数据块,并在集群上并行处理,通过Map和Reduce两个阶段实现数据的分析和处理。

-

YARN资源管理平台:YARN(Yet Another Resource Negotiator)是Hadoop的资源管理平台,用于管理和分配集群中的计算资源。它解耦了MapReduce计算框架和资源管理器,使得Hadoop可以支持更多的计算模型。

-

Sqoop数据迁移工具:Sqoop是Hadoop生态系统中的一个工具,用于在Hadoop和关系型数据库之间进行数据的导入和导出。它可以方便地将关系型数据库中的数据导入到Hadoop中进行分析处理,也可以将处理结果导出到关系型数据库中。

-

Mahout数据挖掘算法库:Mahout是Hadoop的数据挖掘和机器学习的库,提供了一系列常用的数据挖掘算法和工具。它可以在大规模数据集上进行分类、聚类、推荐等任务的分析和建模。

-

HBase分布式数据库:HBase是Hadoop生态系统中的分布式数据库,基于Hadoop分布式文件系统(HDFS)实现。它是一个面向列的数据库,适用于大规模数据的存储和实时查询。

-

Zookeeper分布式协调服务:Zookeeper是Hadoop生态系统中的分布式协调服务,用于协调和管理分布式系统中的各个节点。它提供了分布式锁、命名服务、配置管理等功能,保证了分布式系统的可靠性和一致性。

-

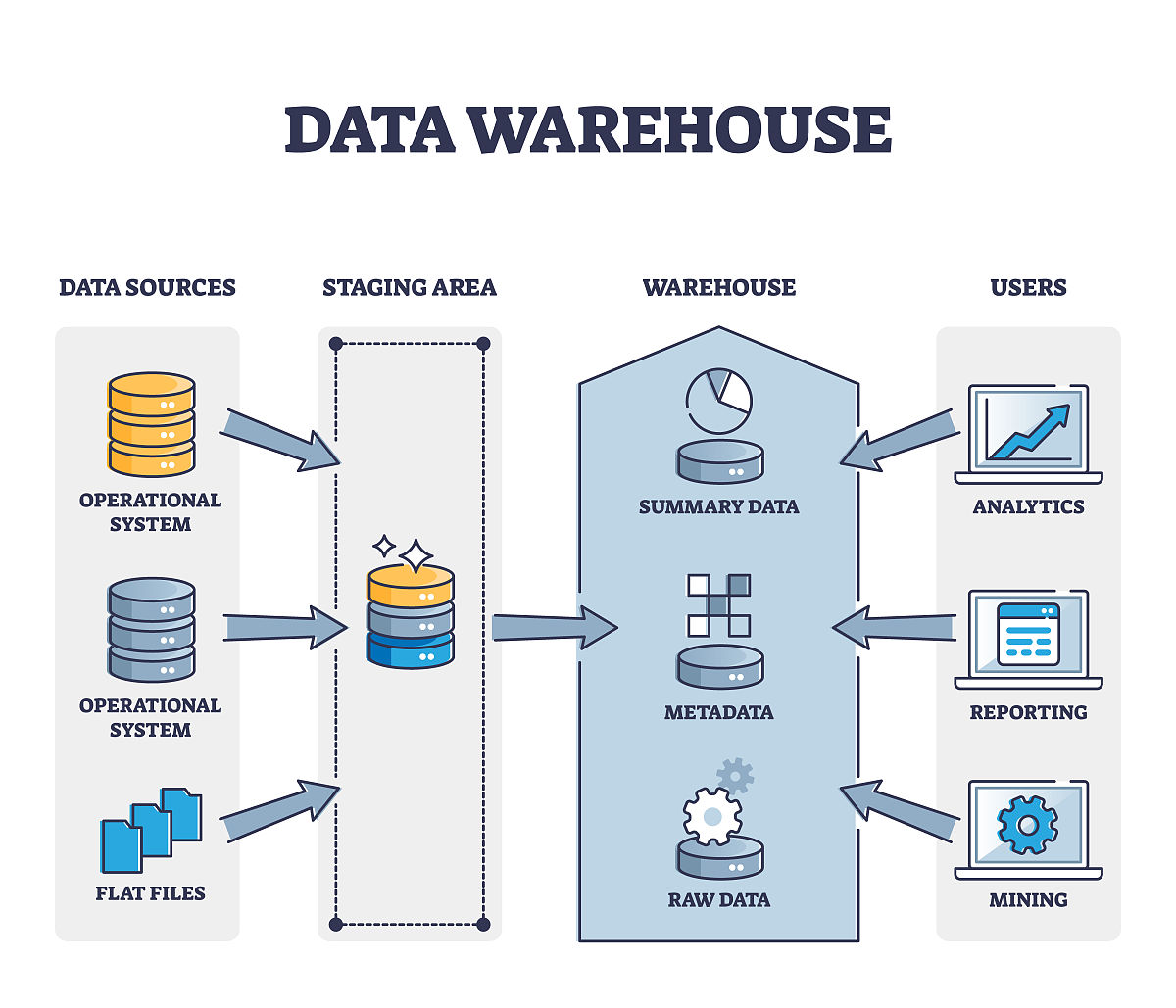

Hive数据仓库:Hive是Hadoop的数据仓库工具,用于处理结构化数据。它将SQL查询转换为MapReduce任务,并通过Hadoop进行分布式处理,提供了类似于SQL的查询语言和数据存储功能。

-

Flume日志收集工具:Flume是Hadoop生态系统中的日志收集工具,用于从各种数据源收集、聚合和移动大量的日志数据。它可以将日志数据传输到Hadoop中进行存储和分析。

通过对Hadoop的各大组件的查找和研究,我对Hadoop有了更深入的认知。Hadoop是一个开源的分布式计算框架,它的核心是分布式存储系统和MapReduce分布式计算框架。通过Hadoop的分布式存储系统,可以实现大规模数据的存储和高可靠性。而MapReduce分布式计算框架则可以将数据切分成多个块,并在集群中并行处理,实现了高性能的数据分析和处理。

除了核心的存储和计算组件,Hadoop还提供了一系列的工具和服务,如数据迁移工具Sqoop、数据挖掘算法库Mahout、分布式数据库HBase等,这些组件的存在丰富了Hadoop的功能和应用场景,使其成为一个完整的大数据处理平台。

通过对Hadoop的研究,我认识到大数据技术的重要性和应用前景。Hadoop作为目前最流行的大数据处理框架之一,可以应对海量数据的存储、计算和分析需求,为企业和研究机构提供了强大的数据处理能力。同时,Hadoop的生态系统也在不断发展和壮大,越来越多的工具和组件被引入,为大数据处理提供了更多的选择和可能性。

在今后的学习和工作中,我将继续深入研究Hadoop及其生态系统的各大组件,不断提高自己的技术能力,并将其应用于实际的数据处理和分析任务中,为企业和社会创造更大的价值

原文地址: http://www.cveoy.top/t/topic/i1WV 著作权归作者所有。请勿转载和采集!