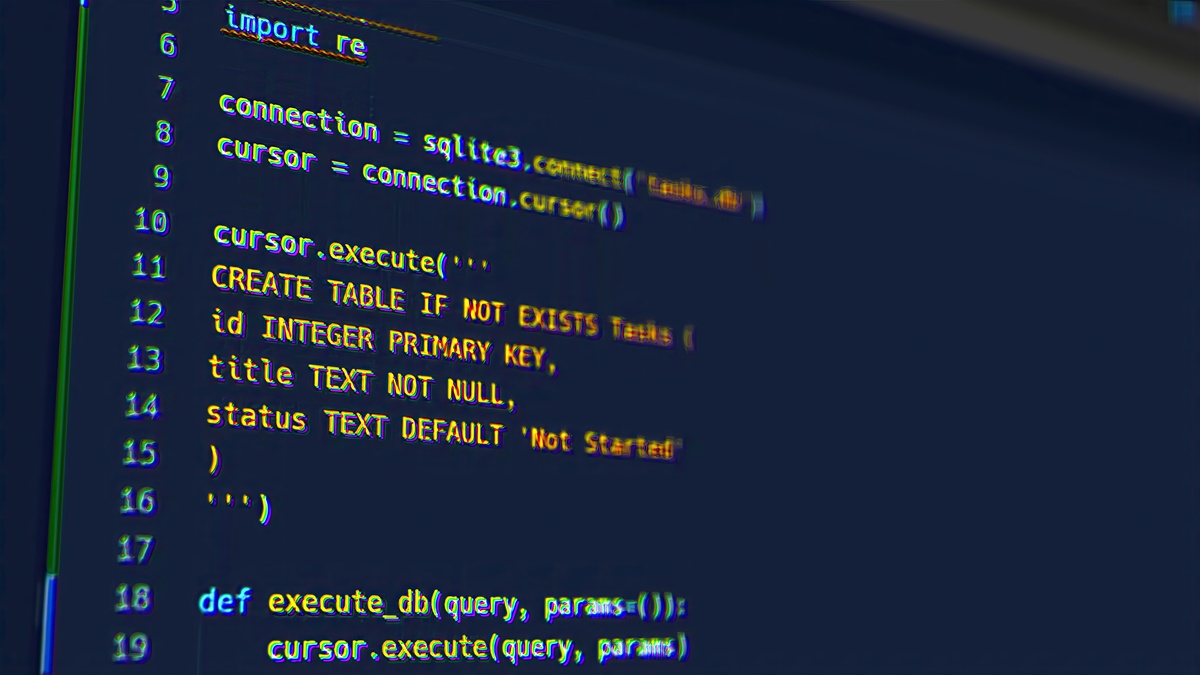

分析以下代码的编辑程序和运行流程并画出流程图import jsonosdatetimefrom os import makedirsfrom ospath import existsimport requestsimport loggingimport refrom urllibparse import urljoinimport multiprocessingloggingbasicConfig

代码的编辑程序和运行流程如下:

-

导入必要的模块和库,包括json、os、datetime、makedirs、exists、requests、logging、re、urljoin和multiprocessing等。

-

配置日志设置,设置日志级别为INFO,格式为'时间 - 日志级别: 日志信息'。

-

定义基本的URL、总页数和结果存储目录。

-

判断结果存储目录是否存在,若不存在则创建。

-

定义函数scrape_page(url),用于爬取指定URL的页面。首先记录日志,然后使用requests库发送GET请求获取页面内容。如果响应状态码为200,则返回页面内容;否则记录错误日志。

-

定义函数scrape_index(page),用于爬取指定页码的索引页面。构建索引页面的URL,然后调用scrape_page函数获取页面内容。

-

定义函数parse_index(html),用于解析索引页面的HTML内容,获取详情页的URL。使用正则表达式匹配详情页URL,并使用urljoin函数构建完整的URL,然后通过yield语句生成器返回URL。

-

定义函数scrape_detail(url),用于爬取指定URL的详情页面。调用scrape_page函数获取页面内容。

-

定义函数parse_detail(html),用于解析详情页面的HTML内容,提取所需数据。使用正则表达式匹配封面、名称、分类、上映日期、剧情和评分等信息,并返回一个包含这些信息的字典。

-

定义函数save_data(data),用于将数据保存为JSON文件。根据数据的名称构建文件路径,然后使用json库将数据以JSON格式写入文件。

-

定义函数main(page),作为主函数。首先记录日志,然后调用scrape_index函数获取索引页面的HTML内容。接下来调用parse_index函数解析HTML内容,获取详情页的URL。然后循环遍历详情页的URL,依次调用scrape_detail和parse_detail函数获取数据,并调用save_data函数将数据保存为JSON文件。最后记录日志表示保存成功。

-

在if name == 'main'语句块中,记录开始时间,创建进程池,定义页码范围,使用pool.map函数并发执行主函数,关闭进程池,记录结束时间,计算并打印程序的运行时间。

流程图如下:

+------------------+

| |

| main() |

| |

+--------+---------+

|

v

+--------+---------+

| |

| scrape_index() |

| |

+--------+---------+

|

v

+--------+---------+

| |

| parse_index() |

| |

+--------+---------+

|

v

+--------+---------+

| |

| scrape_detail() |

| |

+--------+---------+

|

v

+--------+---------+

| |

| parse_detail() |

| |

+--------+---------+

|

v

+--------+---------+

| |

| save_data() |

| |

+--------+---------+

|

v

+--------+---------+

| |

| main() |

| (concurrent) |

| |

+--------+---------+

|

v

+--------+---------+

| |

| main() |

| (concurrent) |

| |

+--------+---------+

.

.

.

``

原文地址: http://www.cveoy.top/t/topic/hDIK 著作权归作者所有。请勿转载和采集!